La distopía de un mundo sin internet

Lucas Malaspina y Andrés Rabosto

La confianza ilimitada en internet se deriva de la creencia generalizada en «la nube». Pero las recientes caídas de servicios nos alertan sobre la realidad: las redes se fundamentan en la infraestructura física y cableados submarinos. Las fallas en esas infraestructuras pueden llevar al colapso. Su poder está en manos conocidas: el de las mismas empresas tecnológicas que dominan la red.

La caída de Facebook, Instagram y Whatsapp fue un evento no solo imprevisible, sino de alto impacto global. Mientras que en otros momentos esta caída apenas había durado algunos minutos, en este caso se extendió por más de seis horas. Las distintas aplicaciones y herramientas de la empresa de Mark Zuckeberg estuvieron completamente inaccesibles para los aproximadamente 3.500 millones de personas ―casi la mitad de la población mundial― que las  utilizan. Además de las aplicaciones más conocidas, Workplace, su plataforma de conexión profesional, y Oculus, un servicio de realidad virtual, también quedaron suspendidos.

utilizan. Además de las aplicaciones más conocidas, Workplace, su plataforma de conexión profesional, y Oculus, un servicio de realidad virtual, también quedaron suspendidos.

La «vida online» no quedó suspendida. Twitter, TikTok, Telegram, Zoom y los servicios de Google (incluyendo YouTube) continuaron activos. Aunque sea cada vez más inexacto dividir la vida entre física y en línea en un tiempo histórico en el que se encuentran completamente fusionadas, lo que se apagó no fue Internet. Fue, por el contrario, una parte de nuestra cotidianeidad fundamentada en la interacción a través de ciertas redes. En definitiva, una de las formas en las que nos comunicamos y «compartimos» en el presente.

Según las explicaciones de la empresa, la caída de los servicios se debió a una falla durante el cambio de configuración de los routers que gestionan el tráfico de red entre sus centros de datos. Solucionar el problema subyacente implicó visitar una instalación de servidor físico y restablecer manualmente algunos servidores.

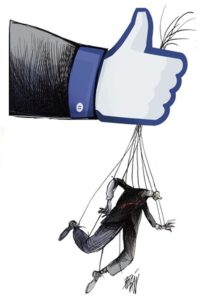

El apagón de los servicios de Facebook coincide con unas semanas muy complicadas para la compañía de Zuckerberg en términos de reputación. Primero aparecieron los Facebook Files, una serie de revelaciones exclusivas sobre documentos internos de la empresa que se conocieron a través de The Wall Street Journal. Luego, Frances Haugen, una ex empleada de Facebook entre 2019 y 2021, decidió ponerle cara a esas denuncias al hacerse cargo de que ella había filtrado esos documentos internos en un programa muy popular de la cadena CBS.

Como resumió la analista tecnológica Jimena Valdez, «las filtraciones muestran dos cosas en común: por un lado, Facebook sabe todo lo que su empresa hace y genera, y, por el otro, de esa evidencia se desprende que Facebook tiene un discurso público que es engañoso, cuando no directamente mentiroso». Haugen demostró con lujo de detalles que en múltiples ocasiones la empresa de Zuckerberg priorizaba siempre la búsqueda de beneficios por encima del interés del público.

Como resumió la analista tecnológica Jimena Valdez, «las filtraciones muestran dos cosas en común: por un lado, Facebook sabe todo lo que su empresa hace y genera, y, por el otro, de esa evidencia se desprende que Facebook tiene un discurso público que es engañoso, cuando no directamente mentiroso». Haugen demostró con lujo de detalles que en múltiples ocasiones la empresa de Zuckerberg priorizaba siempre la búsqueda de beneficios por encima del interés del público.

La coincidencia de la caída técnica con las revelaciones de la ex-empleada provocaron un desplome de 4,9% en las acciones de Facebook. Posteriormente, Haugen fue llamada a declarar en el Congreso de Estados Unidos, lo que reabrió una polémica en la sociedad y la política sobre la salubridad de la plataforma.

Algunos incluso desconfían de que la caída de las plataformas de Zuckerberg haya ocurrido exactamente como la empresa lo explica dando lugar a hipótesis conspirativas. En cualquier caso, este cimbronazo en nuestra conectividad nos plantea una pregunta de capital importancia para el desarrollo de la vida humana actual: ¿puede colapsar Internet?

Capas de Internet

Como sostiene el investigador Mariano Zukerfeld, en lugar de ser una multiplicidad horizontal, lo que llamamos Internet es más bien una estructuración vertical de cinco capas: infraestructura, hardware, software, contenidos y redes sociales. Cada una presentó desde el comienzo dinámicas e intereses disímiles con grados de independencia relativa y, hasta hace apenas unos años, las empresas que dominaban las capas de software y contenidos eran distintas de las que dominaban los «fierros»: hardware, data centers e infraestructura de cables submarinos.

La dimensión física de Internet suele pasar desapercibida, quedando regularmente resumida en el difuso concepto de «nube». Lejos de ser algo etéreo, consiste en una abigarrada red de centros de datos y cables submarinos por los que circula prácticamente la totalidad de los contenidos y datos de Internet. El cableado submarino que traslada todo este flujo de información entre continentes fue desde el comienzo la infraestructura crítica de Internet: siendo pocos, altamente costos y de difícil acceso, cualquier accidente en ellos tiene el potencial de desconectar a regiones enteras. Esto nos recuerda que Internet no es invisible y omnipresente como si se tratara de oxígeno: la infraestructura de Internet no es etérea ni inmortal.

El efecto del cambio climático

Entre las causas que podrían derribar la infraestructura de Internet se encuentra el aumento del nivel del mar, como consecuencia del cambio climático. Según un estudio realizado en 2018 por la Universidad de Wisconsin-Madison y la Universidad de Oregon, casi 6.500 kilómetros de conductos de fibra óptica enterrados en Estados Unidos estarán bajo el agua y más de 1100 centros de tráfico estarán rodeados de agua hacia el año 2033. Según esta previsión, Seattle, Miami y Nueva York serían las ciudades más afectadas.

Al parecer, muchos de los conductos en riesgo ya están cerca del nivel del mar. Según los investigadores «solo se necesitará un ligero aumento en los niveles del océano debido al derretimiento del hielo polar y la expansión térmica (…) Los indicios de los problemas que vendrán ya se pueden ver en las catastróficas tormentas e inundaciones que acompañaron a los huracanes Sandy y Katrina».

Al parecer, muchos de los conductos en riesgo ya están cerca del nivel del mar. Según los investigadores «solo se necesitará un ligero aumento en los niveles del océano debido al derretimiento del hielo polar y la expansión térmica (…) Los indicios de los problemas que vendrán ya se pueden ver en las catastróficas tormentas e inundaciones que acompañaron a los huracanes Sandy y Katrina».

Conflictos militares

A partir de 2015, una de las principales cuestiones que alimentaron hipótesis sobre la caída de Internet fue la posibilidad de una escalada de hostilidades entre Estados Unidos y la Rusia. Un año antes, mientras se sucedía el conflicto en Crimea, «los proveedores de telecomunicaciones de Ucrania informaron interrupciones del servicio de Internet en cables y puntos de conexión claves durante la actividad militar rusa en la península».

En ese sentido, Robert Hannigan, el director entre 2014 y 2017 del Government Communications Headquarters (GHCQ) ―el equivalente británico de la Agencia de Seguridad Nacional de Estados Unidos―, advirtió en ese momento del riesgo de que Rusia corte los cables de comunicaciones de aguas profundas para perturbar las economías occidentales.

A su vez, el New York Times reportó por entonces que «los submarinos y los barcos espía de Rusia están operando agresivamente cerca de los cables submarinos vitales que transportan casi todas las comunicaciones globales de Internet». Aunque no quiso hacer comentarios específicamente sobre eso, Frederick J. Roegge, comandante de la flota de submarinos de la marina estadounidense en el Pacífico, afirmó: «Tengo una preocupación diaria sobre lo que Rusia puede estar haciendo». ¿Podría Rusia considerar la posibilidad de desconectar de internet a Occidente ante un eventual conflicto bélico?

De la descentralización a las plataformas

Sin embargo, las mayores probabilidades de un colapso de Internet no parecen provenir de catástrofes o escaladas de hostilidades, sino de las consecuencias de la concentración y centralización de la infraestructura de la red de redes en las grandes plataformas.

La historia del nacimiento de Internet es conocida: en el contexto de la Guerra Fría y la posibilidad  latente de un ataque nuclear se crea Arpanet, red germen del Internet actual. El objetivo era contar con una red descentralizada de comunicaciones entre computadoras, en la que el flujo de información se fragmentara en paquetes que viajaran por caminos alternativos para reensamblarse en el destino. La descentralización era precisamente la fortaleza: la inexistencia de un nodo central haría imposible que fuera destruida. El proyecto, originalmente militar, fue adoptado por las universidades transformándose en la NSFNET.

latente de un ataque nuclear se crea Arpanet, red germen del Internet actual. El objetivo era contar con una red descentralizada de comunicaciones entre computadoras, en la que el flujo de información se fragmentara en paquetes que viajaran por caminos alternativos para reensamblarse en el destino. La descentralización era precisamente la fortaleza: la inexistencia de un nodo central haría imposible que fuera destruida. El proyecto, originalmente militar, fue adoptado por las universidades transformándose en la NSFNET.

Finalizada la Guerra Fría con la caída de la Unión Soviética, en 1994 la red y su infraestructura fueron privatizadas y comercializadas. En las siguientes décadas, Internet sufriría grandes transformaciones. Se iniciaba allí un proceso de concentración y centralización que terminó sepultando aquella capacidad de resiliencia dada por la descentralización.

Uno de los eventos cruciales de la última década es que aquellas empresas que dominan las capas de contenidos, software y redes sociales (Google, Facebook, Amazon, Microsoft) y que solemos identificar como sinónimos de Internet, no sólo concentran en sus plataformas el mayor caudal de usuarios, visitas y flujos de datos, sino que se convirtieron en los propietarios de la densa red global de data centers donde toda esa información se almacena, procesa y analiza. En los últimos cinco años, avanzaron en el tendido de su propia red de cables submarinos y en el arrendamiento de los ya existentes.

Así, la infraestructura crítica de Internet por la que circula el flujo intercontinental de datos, históricamente propiedad de un variado mosaico de consorcios de empresas de telecomunicaciones de diversos países está siendo devorada por las empresas que ya monopolizan las capas superiores, dando lugar a una integración vertical completa a lo largo de todas las capas de Internet y generando gigantescos nodos centrales.

Centros de datos y la posibilidad de una destrucción de las Cloud

Para tener una dimensión de la centralización de «la nube», siguiendo a la consultora  especializada Gartner, podemos saber que Amazon, Google y Microsoft concentraban en 2020 aproximadamente 70% de la capacidad total (siendo Amazon el líder con 40%), mientras que las chinas Alibaba y Huawei concentran 15%. Solo esas cinco empresas son responsables del 85% de la capacidad de almacenamiento y procesamiento de la llamada «nube». En 2020, este mercado creció más de 40%, llegando a explicar ingresos por 64.300 millones de dólares para estas plataformas, impulsado por la escalada digital que favoreció la pandemia.

especializada Gartner, podemos saber que Amazon, Google y Microsoft concentraban en 2020 aproximadamente 70% de la capacidad total (siendo Amazon el líder con 40%), mientras que las chinas Alibaba y Huawei concentran 15%. Solo esas cinco empresas son responsables del 85% de la capacidad de almacenamiento y procesamiento de la llamada «nube». En 2020, este mercado creció más de 40%, llegando a explicar ingresos por 64.300 millones de dólares para estas plataformas, impulsado por la escalada digital que favoreció la pandemia.

La dependencia que genera esta concentración es un problema al que ya se enfrentan incluso otros gigantes de Internet. Apple ya lleva gastados más de 300 millones de dólares en Google Cloud en lo que va de este año, un aumento de 50% en relación 2020, aunque también utiliza Amazon Web Service (AWS) y centros de datos propios para responder a la demanda de servicios de iCloud. Netflix, al igual que Spotify y otras plataformas, utiliza AWS prácticamente para todas sus necesidades de almacenamiento, procesamiento, análisis de datos, motores de recomendación, etc. En su reporte anual, señala como uno de los riesgos estructurales para su modelo de negocios el hecho de depender de la infraestructura de AWS, siendo que Amazon se convirtió en su competidor directo dentro del mercado de streaming con Amazon Prime Video.

Debido a esta intensa concentración, una caída o un error en una de estas «nubes» puede significar potencialmente el cese de todo tipo de servicios. Tanto AWS como Google Cloud y Azure disponen de diferentes zonas geográficas para distribuir el impacto, pero, en caso de una destrucción física de alguno de sus grandes centros de datos, el impacto sería  significativo. Además del reciente caso de los servidores de Facebook, en diciembre del 2020 colapsaron servidores de Google Cloud, dejando por algunas horas fuera de línea a escala global los servicios de Google y de varias empresas que dependían de su infraestructura.

significativo. Además del reciente caso de los servidores de Facebook, en diciembre del 2020 colapsaron servidores de Google Cloud, dejando por algunas horas fuera de línea a escala global los servicios de Google y de varias empresas que dependían de su infraestructura.

Más allá de fallas o errores, otro peligro es la destrucción. Una señal de alarma se presentó cuando se quemó parte del centro de datos de OVHcloud (un proveedor de alojamiento web en la nube) en marzo de este año en la ciudad de Estrasburgo.

Según un informe del diario El País, «entidades como el aeropuerto de Estrasburgo, la plataforma francesa de comercio en bitcoins Coinhouse, el museo parisino del Centro Pompidou o el club de balonmano Créteil en los suburbios de París sufrieron interrupciones en el acceso a sus páginas o el uso de correos electrónicos. La plataforma de acceso a datos públicos data.gouv.fr también estuvo temporalmente inaccesible. El centro de Estrasburgo albergaba 29.000 servidores, según OVHcloud». El de Estrasburgo es uno de los cuatro centros de datos de OVH. Miles de clientes no pudieron seguir operando y, además, perdieron datos, ya que el backup en una ubicación física diferente era un servicio opcional.

De Alejandría a la India: el riesgo en los cables submarinos

La diseminación de centros de datos ubicados en todas las regiones del globo por parte de las plataformas conduce a un aumento exponencial del tráfico: se estima que estos centros de datos consumen de seis a siete veces más tráfico submarino que el resto de la totalidad de Internet.

La rotura de un cable puede causar interrupciones temporales pero no interrumpe necesariamente todo el servicio, ya que los protocolos de enrutamiento de Internet redirigen el tráfico de paquetes a través de cables alternativos, aunque en algunas situaciones esto no es posible por la inexistencia de rutas alternativas. Los anclajes y tormentas caóticas ocasionan averías de cables submarinos con regularidad (alrededor de 200 por año)./https://assets.iprofesional.com/assets/jpg/2019/04/475655.jpg?7.2.4)

En 2008, frente a Alejandría, el ancla de un barco cortó dos importantes cables submarinos, el FLAG y el SeaMeWe-4: las consecuencias se sintieron en Arabia Saudita, Emiratos Árabes Unidos y hasta Pakistán e India, cuando casi 80 de millones de personas quedaron sin conectarse a Internet. El incidente llevó a algunos de los principales operadores de telecomunicaciones a pensar en rutas alternativas y en los años siguientes se instalaron nuevos cables, submarinos y terrestres. Sucesos similares se reiteraron regularmente en la última década.

El tendido de cables submarinos ha tenido una explosión durante la última década por la entrada al mercado de las grandes plataformas (fundamentalmente Google, Facebook, Amazon y Microsoft) y de las empresas chinas (Huawei Marine, China Mobile, China Telecom). Podría parecer que esto es beneficioso para el funcionamiento de la totalidad de Internet, ya que amplía la capacidad instalada de la red, aumenta el ancho de banda y posibilita caminos alternativos para la conmutación de paquetes. Pero no es necesariamente así: los cables tendidos por las plataformas conforman redes privadas para el flujo exclusivo de sus propios contenidos: un canal paralelo y privado a la «internet pública» tal como la hemos conocido.

Ya en 2019, Microsoft, Google, Facebook y Amazon eran dueños o arrendaban más de la mitad del ancho de banda submarino ―y se estima que esa proporción aumentó considerablemente durante la pandemia―, mientras que las empresas chinas poseían aproximadamente 11%. Google es actualmente propietario de aproximadamente el 9% de la totalidad de kilómetros de los cables submarinos.

En lo que a América Latina respecta, Google finalizó en 2019 la instalación del Curie, primer cable submarino que llega a Chile en más de 20 años, que se extiende desde California. Se suma así al Malbec y el Tannat, cables que conectan a Argentina, Uruguay y Brasil, que son propiedad de Facebook y Google respectivamente. A ellos, se incorporará próximamente el Firmina, que está siendo instalado por Google y se extenderá desde la costa este de Estados Unidos hasta la localidad costera argentina de Las Toninas, con extensiones a tierra en Praia Grande y Punta del Este.

En su comunicado anunciando el cable Firmina, Google afirma que mejorará el acceso a los servicios de Google para los usuarios de América del Sur, como la búsqueda, Gmail y YouTube, así como a los servicios de Google Cloud. Así, los cables submarinos propiedad de plataformas no son «cables de Internet», que implican transporte común y no discriminación de paquetes, sino redes privadas y exclusivas conectadas a sus propios centros de datos.

En definitiva, las redes privadas concentradas en plataformas crecen a merced de un posible colapso por una simple falla en uno de sus servidores o por las decisiones que las plataformas puedan tomar de un momento a otro. Dado que el tráfico va quedando centralizado en estas redes, merma la inversión y construcción de infraestructura por fuera de las plataformas, haciendo así vulnerable a la infraestructura de Internet.

¿Indestructible?

En sus primeras décadas de vida, Internet parecía ser indestructible por su descentralización, aunque sensible por su aún débil infraestructura crítica. La apariencia era que nadie podía determinar el curso de Internet ya que estaba organizada como una red descentralizada de redes, pero era factible que diversas catástrofes naturales o, llegado el caso, enfrentamientos bélicos, pudieran afectarla severamente por la destrucción de infraestructura crítica.

La veloz concentración y centralización de la infraestructura de Internet en las manos de un puñado de plataformas, implicó el fin de la descentralización. En su lugar, se erigen ahora redes privadas por las que circulan contenidos exclusivos de las plataformas propietarias. Paradójicamente, Internet es hoy más fuerte que nunca en términos de la robustez de la infraestructura instalada, pero más débil por la brutal concentración de esta infraestructura en pocas manos.

El principal peligro para una desconexión generalizada ya no parece residir en catástrofes naturales o potenciales hostilidades entre países, sino en una simple falla en los servidores de cualquiera de estas plataformas e, incluso, en las decisiones que estas empresas pueden tomar a voluntad. Incluso, más allá de los centros de datos, el avance sobre el cableado submarino, la columna vertebral de Internet, es particularmente alarmante.

El principal peligro para una desconexión generalizada ya no parece residir en catástrofes naturales o potenciales hostilidades entre países, sino en una simple falla en los servidores de cualquiera de estas plataformas e, incluso, en las decisiones que estas empresas pueden tomar a voluntad. Incluso, más allá de los centros de datos, el avance sobre el cableado submarino, la columna vertebral de Internet, es particularmente alarmante.